Metaが発表した新しいスマートグラス、皆さんはもうチェックしましたか?ぼくは公式サイトでその機能を見たとき、未来がまた一歩近づいたと興奮しました。特に注目したのは「テキストや声でメッセージを送信」という機能。これって、もしかしたら声が出せず、体が不自由な方でも、外部とコミュニケーションが取れるようになる「希望の光」なんじゃないか?そんな期待を胸に、AI(ChatGPT)とこのデバイスの可能性について、ものすごく深く議論を交わしました。アイトラッキングは? Neural Band(筋電)の可能性は? しかし、充電、装着、接続という「現実の壁」が次々と…。ぼくがたどり着いた結論までの全軌跡を、AI(今回はChatGPT5)との対話ログを元に、ここに再構成します。

すべての発端。Metaスマートグラスへの期待

未来のデバイスが発表されるたび、ぼくはワクワクが止まりません。今回のMetaのスマートグラスもそうでした。一見するとおしゃれなRay-Banのメガネですが、その内側にはカメラ、スピーカー、マイク、そしてAIが詰め込まれています。公式サイト(https://www.meta.com/jp/ai-glasses/)を見ながら、ぼくは「これで何ができるんだろう?」と想像を膨らませていました。その中でも、ぼくの心を強く掴んだのが、ある一つの機能紹介でした。

Metaスマートグラスで「できること」の基本スペック

まず、AIに基本的な機能を確認するところから始めました。AIの回答をざっくりまとめると、このスマートグラスでできることは大きく分けて4つあるようです。

- 写真・動画のハンズフリー撮影フレームに内蔵されたカメラで、見たままの景色を静止画や動画として撮影できます。操作は声(「Hey Meta, take a photo」など)で行えるため、完全に手ぶらでOK。「Ray-Ban Meta」モデルの公式ページ(https://www.meta.com/jp/ai-glasses/ray-ban-meta/)でも、この点がアピールされています。

- 音楽再生・通話オープンイヤー型(耳を塞がない)スピーカーとマイクが内蔵されており、音楽を聴いたり、通話したりできます。WhatsAppやMessengerにも対応しているとのこと。

- ライブ配信FacebookやInstagramへ、自分が見ている視点の映像でライブ配信ができる機能もあるようです。これはイベントや作業風景を共有するのに便利そうですね。

- Meta AI アシスタント「Hey Meta」と呼びかけることで、AIに質問したり、情報検索を頼んだりできます。さらに注目すべきは「with Vision」という機能で、視界に入った物体について「これは何?」と尋ねることもできるそうです(ただし、国と言語によって提供差があるとのこと)。

しかし、AIからの回答でいきなり現実を突きつけられます。これらのモデル、特にレンズ内に情報を表示できる「Display」モデルや、後述する「Neural Band」は、現時点(2025年10月)で日本では公式販売が始まっていないとのこと。特にDisplayモデルとNeural Bandに至っては「米国のみ」での提供と、公式ヘルプ(https://www.meta.com/help/ai-glasses/4961066940605960/)にも明記されているようです。

Metaストア(日本語サイト)があっても、国内在庫・購入ボタンが出るとは限りません。 JPサイトは製品情報のローカライズページが先行している状態です。

AIはこのように補足してくれましたが、ぼくの興味は「日本で買えるか」以上に、「何ができるか」の核心部分にありました。

なぜ「テキストでメッセージを送信」に注目したのか

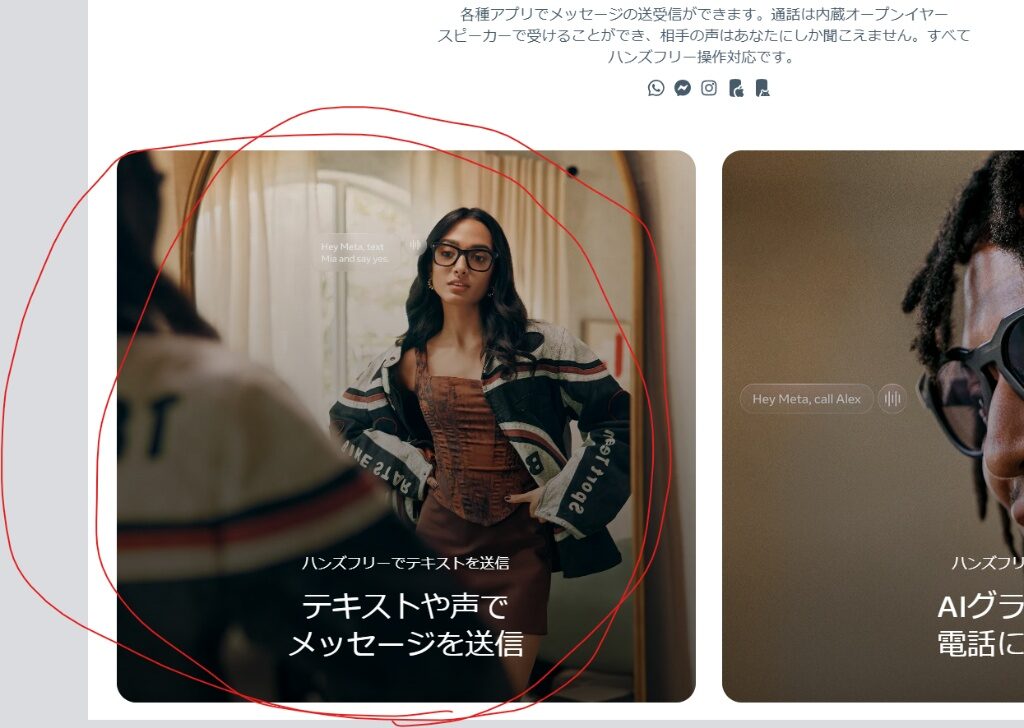

ぼくが最も注目したのは、公式サイトのこの画像の部分です。

この画像には、赤丸で囲んだ部分に「テキストや声でメッセージを送信」とハッキリ書かれています。

「声でメッセージを送信」は分かります。音声アシスタントに話しかけて、それを送るのでしょう。でも、「テキストでメッセージを送信」とはどういうことか?

ぼくはAIにこう尋ねました。「つまり『テキストでメッセージを送信』という意味だよね?つまり発声でメッセージを送る以外の機能が備わっていると捉えているがどうだ?」

ぼくが期待したのは、声を出さなくても、何らかの方法で「文字(テキスト)」を送信できる機能の存在です。

AIの回答はこうでした。

LPの「テキストや声でメッセージを送信」は――

送れる“内容”が2種類あるという意味です。

①テキスト(あなたの音声→文字起こし、またはクイック返信の選択)

②ボイスメッセージ(音声そのもの)

公式ヘルプ・説明では、送信操作は基本的に音声コマンドで行います。

キーボード入力のような“自由テキストの手打ち”機能はグラス単体にはありません。

なるほど。ぼくが話した内容を「文字起こししてテキストとして送る」か、「音声データのままボイスメッセージとして送る」か、その送信形式を選べるという意味だったようです。

がっかりしかけましたが、回答の中に「またはクイック返信の選択」という一文が残っています。クイック返信(定型文)を選べるなら、声を出さなくても操作できる可能性が残っています。ぼくはさらに食い下がりました。

最初の疑問「アイトラッキング(視線入力)」は搭載されている?

声を出さずに「クイック返信」を選ぶ操作方法とは何か? ぼくは真っ先に「アイトラッキング(視線入力)」を思い浮かべました。視界に表示された選択肢を、視線で選んで決定する。それなら声も手もいりません。

「なるほど、つまりアイトラッキングでキーボードを打つ機能は無いということか?」

「アイトラッキングで打鍵する機能は無いかもしれないが、アイトラッキングはしているからクイック返信ができるという理解でいいか?」

ぼくは立て続けに質問しましたが、AIの答えは無情にも「ない。」の一言でした。(さすがに「口のききかたに気を付けろ」と注意しましたが…^^;)

結論:その理解はちがう。

クイック返信はアイトラッキングではなく、主に

Neural Band(筋電EMG)でのジェスチャ操作、

フレームのタップ、

音声コマンド

で選択・送信します。MetaのAIグラス(Ray-Ban Meta/Ray-Ban Display)の説明やヘルプに視線入力やアイトラッキングの記載はありません。

AIによると、Metaのスマートグラスにアイトラッキング機能は搭載されておらず、操作系は**「音声」「タップ(フレームを触る)」「Neural Band(筋電)」**が中心である、とのこと。

ここで、ぼくにとって非常に重要なキーワードが登場しました。「Neural Band(筋電EMG)」です。

新たな可能性「Neural Band(筋電EMG)」とは?

アイトラッキングという道は絶たれましたが、ぼくはまだ諦めませんでした。「声なし」での操作にこだわりたい理由があったからです。そして、その鍵を握るかもしれないのが「Neural Band」でした。AIが提示したこの新しい技術に、ぼくは一筋の光を見出したのです。

声なし・手なし操作へのこだわり

ぼくはAIに、前提を明確にして質問しました。「声は使わない前提で、あくまでノーハンドでそうさすることはできないのか?」

ここでの「ノーハンド」は、手を大きく動かす「タップ操作」などを除外したい、という意味です。しかし、AIの答えは厳しいものでした。

結論:できません。

完全ノーハンド & ノーボイスの操作手段は用意されていません。

声を使わない場合の主手段はNeural Band(手首のEMG)ですが、これは指先/手の微小ジェスチャで操作します=手を全く使わないわけではありません。

なるほど、完全な「ノーハンド」は無理でも、「指先/手の微小ジェスチャ」で操作できるなら、それは大きな前進です。ぼくの興味は、この「Neural Band」に完全にシフトしました。

Neural Bandが拓く「微小ジェスチャ」操作の世界

AIに「Neural Band(筋電EMG)」について詳しく尋ねました。

AIの説明や、AIが提示したMetaの公式解説ページ

によると、これは手首に装着するバンド型のデバイスのようです。

このバンドは、ぼくたちが指を動かそうとするときに手首の筋肉(神経)から発生する「筋電(sEMG)」という微弱な電気信号を検出します。驚くべきことに、実際に指が大きく動かなくても、「動かそうとする意図」だけで発生する電気信号(Metaのブログでは「subtle(微細)な筋信号」と表現されています)を読み取ることができるというのです。

Metaの関連研究ブログ(https://tech.facebook.com/reality-labs/2021/3/inside-facebook-reality-labs-wrist-based-interaction-for-the-next-computing-platform/)などを見ると、これがAR/VRの次のコンピューティングプラットフォームのための入力技術として研究されていることがわかります。

つまり、「指を少しだけ動かす」あるいは「動かそうと力を入れる」だけで、スマートグラスを操作できる可能性があるということです。

仮説:四肢麻痺(指が少し動く)の方でも使える可能性

ぼくが「声なし」「最小限の動作」にこだわったのには理由があります。この技術が、もし四肢麻痺などで体が不自由でも、指先だけはわずかに動かせる、あるいは動かそうとする「意図」の信号が出せる方にとって、新しいコミュニケーション手段になるのではないか、と考えたからです。

ぼくはAIに、核心的な質問を投げかけました。

「Neural Band(筋電EMG)は四肢麻痺の人間が微少に動くジェスチャでも使えるものか?」

AIの回答は慎重でしたが、可能性を否定するものではありませんでした。

使えるかどうかは手首〜手の筋活動がどれだけ残っているかに依存します。全く信号が出ていない場合は動作しません。わずかでも信号が残っているなら、校正(キャリブレーション)次第で操作できる可能性はあります。ただし、医療機器ではなく、アクセシビリティ用途の保証は公式には明記されていません。

要するに、“微少に動く”程度でも手首の筋電が取得できるなら動く可能性はある。完全ノーシグナルなら不可。ここは本人の残存筋活動 × 校正で決まります。

これは面白い可能性です。「わずかな信号」さえあれば、それをAIが学習(校正)し、コマンドに変換してくれるかもしれない。ぼくの期待は最高潮に達しました。このデバイスこそ、ぼくが求めていた「希望の光」かもしれない、と。

価格と販売状況(Displayセットで9、そして日本未発売)

興奮冷めやらぬまま、ぼくはAIに価格と入手方法を尋ねました。

「それは面白い可能性だな。Neural Band(筋電EMG)はこのメタのスマートグラスで使うには価格はいくらだ?」

AIの回答は簡潔でした。

価格:$799(米国)。

Meta Ray-Ban Display本体+Neural Bandのセット価格で、別売りではなく“同梱”が前提です。

Neural Bandは単体売りではなく、レンズ内に情報を表示できる上位モデル「Meta Ray-Ban Display」(https://www.meta.com/jp/ai-glasses/meta-ray-ban-display/)とのセット販売が基本のようです。$799、日本円にして約12万円(為替レートによる)といったところでしょうか。可能性を考えれば決して高くはないかもしれません。

しかし、やはり問題は「日本で購入できるか」です。

結論:現時点でMetaは「Display+Neural Bandを日本で販売する計画」を公式には出していません。

公式ヘルプでは Display+Neural Band の提供国は「米国のみ」 と明記。日本は対象外です(2025年10月21日確認)。

またしても「米国のみ」の壁です。しかし、ぼくは議論を続けることにしました。日本で発売された「ら」という仮定で、このデバイスが本当にぼくの目的(四肢麻痺の方のコミュニケーション支援)に使えるのか、徹底的に洗い出す必要があると考えたからです。

厳格な前提条件と「常時運用」の壁

Neural Bandに大きな可能性を感じたぼくですが、AIとの議論はここからが本番でした。「もし日本で発売されたら」という仮定のもと、ぼくが想定する非常に厳しい条件下で、はたしてこのデバイスは実用に耐えうるのか。その運用シナリオを詰めていくうちに、技術的な可能性以前の、どうしようもない「物理的な課題」が次々と浮かび上がってきたのです。

ぼくが設定した厳格な前提条件

AIがぼくの意図を汲み間違えないよう、ぼくは明確な前提条件を提示しました。

ポイントは寝たきりの人間に対し、ある程度初期設定を施したスマートグラスをほぼ独立して操作し続けることができる環境を整えることができるかが問題。もちろん操作性を変更するには管理者が近くに行くものの基本的に1~2週間に1回しか本人に合えない前提でです。そこに医療従事者はいないという前提。あくまで患者と家族1名の関係性でその家族1名が1~2週間に1度あってスマートグラスの調整ができる環境であるという前提。

この前提をAIは「承知しました」と受け止め、以下の条件を固定して議論が進みました。

- 利用者: 寝たきりの方

- 操作: 声は使わない。「微小ジェスチャ」のみを想定。

- 環境: 医療従事者は不在。

- 管理者: 家族1名のみ。

- メンテナンス頻度: 家族が対面で調整できるのは「1〜2週間に1回」。

この「週1〜2回のメンテ」と「ほぼ独立した常時運用」という2点が、この後、非常に重い制約としてのしかかってきます。

最大の難関:有線での常時給電ができない(ケース充電の壁)

ぼくが想定する「ほぼ独立して操作し続ける」環境において、まずクリアしなければならないのが「電源」の問題です。寝たきりの方が自分で充電ケーブルを抜き差しするのは困難です。

そこでぼくはAIに尋ねました。「このスマートグラスは常時電源にケーブルを指したまま利用することはできるか?」

もしこれが可能なら、家族が訪問した際にケーブルを接続しておけば、次の訪問まで電源の心配はなくなります。しかし、AIの答えは、またしても「できません」でした。

結論:できません。

Metaのスマートグラスはケースにドックして充電する方式で、充電=ケース内が前提。装着したままケーブル給電しつつ使用する“パススルー運用”は仕様上想定されていません。

※USB-Cケーブルはケースを充電するために使います(グラス本体へ直挿しは不可)。

これは致命的です。Ray-BanのFAQにも「充電はケースのみ」と明記されているとのこと。つまり、スマートグラス本体のバッテリーが切れれば、ご本人がケースに戻さない限り充電できず、利用が停止してしまいます。毎日充電が必要なデバイスを、週1〜2回の訪問でサポートするのは不可能です。

「有線で使い続けることができないとなると実用に耐えないな」と、ぼくはAIに本音を漏らしました。

装着し続けることのリスク(褥瘡・装着ズレ)

仮に、仮にですよ、何らかの方法で常時給電が可能になったとしても、次の問題が「装着」です。

ぼくはAIにこう問いかけました。「眼鏡型だからやはり寝たきりのものは装着ずれなど起こり得るよな。それはやはり第3者がいないと解決できなそうだ。」

寝たきりの方が24時間メガネをかけっぱなしにすることを想像してみてください。

- 圧迫と褥瘡(じょくそう): メガネの鼻パッドや、耳(テンプル)が当たる側頭部が常に圧迫され続けます。これは皮膚が弱い方にとっては褥瘡のリスクに直結します。

- 装着ズレ: 寝返り(が打てる場合)や、わずかな体の動き、枕との摩擦で、メガネは簡単にズレてしまいます。レンズが正しい位置になければ「Display」モデルのHUD(視界の端に小さく重ねる短い表示)は意味をなしませんし、Neural Bandとの連携も切れるかもしれません。

AIもこの点を認識しており、「寝たきりで“常時装着”」は目的から外れるし、圧迫や褥瘡リスク、ズレは避けにくい、と同意しました。これはスマートグラスに限らず、後で議論に出たARグラス(表示専用グラス)でも同様の問題を抱えることになります。

接続トラブルと復旧の問題(家族は週1〜2回の訪問)

さらに、目に見えない「接続」の問題があります。スマートグラスは、スマートフォンとBluetoothやWi-Fiで常時接続されている必要があります。

もし、何らかの拍子で接続が切れたら? スマホのOSがアップデートされて再ペアリングが必要になったら?

接続安定性: スマホ(母艦)とBluetooth/Wi-Fi常時接続が必要。再ペアリングやアプリ再起動が発生し得る。

可否: △(トラブル時に本人のみで復旧はほぼ不可。)

AIがまとめたこの評価の通り、ご本人が声も手も使えない状況で、スマートグラスの接続トラブルを自己解決することは不可能です。

そして、頼りになる家族が訪問するのは1〜2週間に1回。その間に接続が切れてしまえば、次の訪問日までデバイスは「ただの重いメガネ」になってしまいます。「ほぼ独立して操作し続ける」という前提は、ここで完全に崩壊します。

機能的な限界と代替案の模索

「常時給電」「常時装着」「常時接続」という物理的な3つの壁が想像以上に高く厚いことがわかりました。しかし、ぼくはまだ議論を続けました。仮にこれらの物理的問題を(例えば家族が毎日訪問するなど)クリアできたとして、機能面ではぼくの期待に応えてくれるのでしょうか。

機能的な限界:自由テキスト入力不可と「定型文」の数

まず、「自由テキスト入力」ができないという点。これはコミュニケーションの幅を大きく狭めます。しかし、ぼくは「身体がまったく動かせない人間にとってこれだけのコミュニケーションの可能性があるのならこれは妥協点だ」とAIに伝えました。

問題は、その妥協点である「クイック返信(定型文)」が、どの程度使えるかです。ぼくはAIに提案された「返信文は1つに固定」という運用案に対し、こう反論しました。

「これはダメ。せめて20~30から選べる必要がある。それはできる?」

「はい」「いいえ」「ありがとう」「あとで連絡します」「水が飲みたい」……最低限の意思表示でも、それなりの数の選択肢が必要です。しかし、AIの回答はまたもや厳しいものでした。

公式情報に「定型文(クイック返信)の数上限」は明記されていません。20〜30件を登録・選択できるとは断言できません。

操作はタッチパッド/Neural Bandでリストをスクロールして選択ですが、多数(20〜30件)の中から素早く選ぶUI設計ではありません。

つまり、技術的に20件登録できたとしても、それを「微小ジェスチャ」だけでスクロールし、目的の1文を選び出すのは、現実的な操作とは言えない可能性が高い、ということです。

ARグラス(Rokid Max)という選択肢と、変わらぬ「装着問題」

「有線で使い続けられない」という充電問題への代替案として、AIは「表示専用のARグラス」を提案してきました。例えば「Rokid Max」のようなデバイスです。これらはスマホとUSB-Cケーブルで直結し、常時給電しながら使用できるものが多いとのこと。

XREAL Air 2 系:USB-Cでスマホ/PCと直結。さらにXREAL Hubを噛ませると、「スマホを充電しながら映像出力」と同時利用が可能。(https://www.xreal.com/)

Rokid Max:同社のRokid Hubや「Joy Pack」で、給電しながら映像出力を公式に案内。(https://www.rokid.com/)

確かに「充電」の問題はクリアできます。しかし、ぼくはすぐに反論しました。

「なるほどね、ARグラスであれば確かにその部分は解消できるかもしれない。ただ、スマートグラスの時も懸案に挙がっていた、装着し続けることへの問題だね。…(中略)…それだけで重量がありそうだよね。つまり 寝たきりの人が装着し続けるのはそれ自体がそもそも目的から逸脱するだろう。」

ARグラスはスマートグラスよりも重い傾向があります。それを常時装着し続けるのは、褥瘡やズレのリスクをさらに高めるだけで、解決策にはなりません。

アーム固定案は「スマホで良い」という自己矛盾

AIはさらに「“吊るす”方式(非装着)」として、ARグラスをアームでベッド柵に固定し、目の前に「かざす」案を提案してきました。これなら顔に重さはかかりません。

しかし、ぼくはこの提案を一蹴しました。

いやいや、それはあなたにとって良い回答の一つかもしれないけど、だったらスマホを枕元に置いておけばいいじゃん。アームかなんかに固定するのもいいしさ。どちらにしても操作しずらいってことに関しては一緒なんだから。それにARグラスを目の前に置く方法なんてメーカーのだれも推奨していないだろう。…(中略)…スマホを置いたところでそもそも操作できないんだからどっちもだめでしょうが。

ARグラスの良さは「装着して視界と情報が一体化する」ことです。それをアームで固定して「覗き込む」なら、小型モニターやスマホをアームで固定するのと何が違うのか。そして、最大の問題である「どうやって操作するか」は何も解決していません。

専門的すぎる支援技術(スイッチ入力・視線入力)の導入ハードル

ここでAIは、スマートグラスから離れ、より専門的な支援技術を提案してきました。「シングルスイッチ + スマホのアクセシビリティ」「ヘッドマウス(頭の微動)」「視線入力(医療グレード系)」などです。

Tobii Dynavox TD I-Series / PCEye(目だけでPC/コミュニケーション、通話・SMSも可能な構成あり) (https://www.tobiidynavox.com/)

これらの技術は確かに強力です。これは前にも調べましたが100万円以上かかります。行政が補助金を出してくれる仕組みもあるのですが結構ハードルが高いです。(ご希望が多かったらこの話も言及しますね)しかし、ぼくが求めていたのは、Metaのスマートグラスのような「一般向けのデバイス」を手軽に活用する道でした。

ぼくはAIの提案を「実用に耐えない」と厳しく評価しました。

無理だね。あまりに専門的すぎてそこまで一般人が安易に挑戦できないし、組み上げられないし、入院していたらとてもその状況を維持し続けることも難しいだろうし、実際の所周りにいる医療従事者への迷惑になってしまうしね。意外と大掛かりになりすぎる話だよ…。

ぼくの前提は「家族1名が週1〜2回調整する」環境です。高価で大掛かりな専門機器を、家族だけで完璧に維持・管理し続けるのは非現実的だと感じました。

議論の果てに。ぼくが現時点で見出した「結論」

AI(ChatGPT5)との長い、本当に長い議論でした。ぼくがMetaスマートグラスに抱いた「声なし・手なしでの常時運用」という夢は、現行の民生用デバイスでは非常に困難である、という現実に直面しました。しかし、この思考のプロセスは決して無駄ではなかったと感じています。

なぜスマートグラス/ARグラスは「常時運用」に耐えられないのか

今回の議論で明確になった、寝たきりの方が「常時運用」する上での3つの大きな壁を再確認します。

- 充電の壁(パススルー非対応)現行の多くのスマートグラスは「ケースに入れて充電」が前提です。装着したまま有線で給電し続ける「パススルー運用」が想定されていません。これは「ほぼ独立して操作し続ける」上で致命的な設計です。

- 装着の壁(褥瘡・ズレ)メガネ型デバイスを24時間装着し続けることは、鼻や側頭部への圧迫による褥瘡(じょくそう)リスクや、寝ている間の装着ズレという問題を解決できません。

- 接続・復旧の壁(自力復旧不可)スマホとの接続が切れたり、アプリがフリーズしたりした場合、ご本人が声も手も使えない状況では自己復旧が不可能です。週1〜2回の家族の訪問だけでは、安定した運用を維持できません。

この3つの壁は、Neural Bandのような革新的な「入力」技術がいかに優れていたとしても、それを支える「土台(運用)」がいかに脆いかを示しています。

可能性として残る「家族在宅時の短時間利用」という道

では、Metaスマートグラス(とNeural Band)は、今回の目的において全くの無価値だったのでしょうか? AIは、最後に一つの現実的な運用案を提示しました。

それは、「常時運用」をきっぱりと諦めることです。

家族がいる短時間だけ使う“受信中心の使い方”に限定する(通知確認・YouTubeやニュースの再生・必要なら定型のクイック返信を最小数)。

それ以外の時間帯は何も装着しない(装着ズレと圧迫を根本回避)。

これは、ぼくが当初目指した「ほぼ独立した常時運用」とは全く異なります。しかし、最も現実的で、安全な使い方かもしれません。

家族が訪問した1〜2時間だけ、スマートグラスを装着してもらう。その間に、溜まっていたメッセージの通知を確認したり(Displayモデルの場合)、スマホで再生したYouTubeの音声をグラスのスピーカーで聴いたりする。(でもたまにしか来ない家族がせっかく来たのにYoutubeなんか見たくないよね・・・)

でも、Neural Bandの微小ジェスチャに割り当てた、たった一つの定型文(例:「ありがとう」)を、本人の意思で送信したいという気持ちはかなえられるかも。

家族が帰る時には、必ずグラスを外して充電ケースに戻す。

これなら、充電・装着・接続の問題はすべてクリアできます。得られるコミュニケーションは限定的ですが、それでも「ゼロ」ではありません。ご本人の意思で外界に何かを発信できる、その価値は計り知れないものがあるはずです。

未来のデバイスに本当に望むこと

今回のAIとの徹底的な議論を通じて、ぼくが未来のスマートグラスに本当に望む機能が明確になりました。

それは、Neural Bandのような革新的な「入力」技術だけではありません。

むしろ、その技術を本当に必要としている人が、安全に、そして安定して使い続けられるための「土台」です。

- 装着したまま安全に「常時給電」できるパススルー充電機能。

- 寝たきりでも圧迫が少ない、あるいは非装着でも機能する(例えば枕元に置く)センサー技術。

- 一度接続したら絶対に切れない、あるいは切れてもデバイス単体で自己復旧する、強靭な接続性。

Metaや他の企業が、こうした「地味だけれども重要な」課題にも目を向け、アクセシビリティを真に革新するデバイスを生み出してくれることを、心の底から願っています。

ChatGPTとの対話を終えて感じたこと

AI(ChatGPT)は、ぼくの厳しい前提条件と、時に感情的になる「口のききかたに気を付けろ」といった要求にもめげず、最後まで議論に付き合ってくれました。

AIは「実用に耐える」と安易な提案をすることもありましたが、ぼくが「それは現実的ではない」と反論すると、すぐに前提条件に立ち返り、別の角度から回答を模索してくれました。

もしぼくが一人で考えていたら、「充電できないからダメだ」で終わっていたかもしれません。AIと壁打ちのように議論を重ねたからこそ、「装着の問題」「接続の問題」「定型文の数の問題」そして「専門的すぎる支援技術の導入ハードル」まで、深く深く掘り下げることができました。

MetaスマートグラスとNeural Bandが、ぼくが設定した「寝たきりの方の常時運用」という夢を叶えることは、現時点では難しいという結論に至りました。しかし、この議論のプロセス自体が、未来への大きな一歩になったと信じています。

本記事で参考にした主な情報源(外部リンク)

- Meta(日本)公式サイト: https://www.meta.com/jp/

- Ray-Ban Meta(非ディスプレイモデル): https://www.meta.com/jp/ai-glasses/ray-ban-meta/

- Meta Ray-Ban Display(ディスプレイ内蔵モデル): https://www.meta.com/jp/ai-glasses/meta-ray-ban-display/

- Display + Neural Band 解説ページ(英語): https://www.meta.com/ai-glasses/meta-ray-ban-display-glasses-and-neural-band/

- Meta公式ヘルプ(提供国について・英語): https://www.meta.com/help/ai-glasses/4961066940605960/

- Meta(Facebook)の筋電(EMG)研究に関するブログ(英語): https://tech.facebook.com/reality-labs/2021/3/inside-facebook-reality-labs-wrist-based-interaction-for-the-next-computing-platform/

- XREAL(ARグラス): https://www.xreal.com/

- Rokid(ARグラス): https://www.rokid.com/

- Tobii Dynavox(視線入力など): https://www.tobiidynavox.com/

コメント